- Un científico afirma que la singularidad llegará en 2031

- ¿Cuándo logrará la humanidad la singularidad?

- ¿Se puede democratizar la inteligencia artificial?

En un nuevo y provocador artículo, un científico inglés se pregunta si la llamada "inteligencia artificial" (IA) es una de las razones por las que nunca hemos encontrado otros seres inteligentes en el universo. La paradoja de Fermi recoge esta idea: en un universo infinito, ¿cómo es posible que no haya otras civilizaciones que nos envíen señales de radio? ¿Podría ser que, una vez que las civilizaciones desarrollan IA, para la mayoría de ellas es un corto viaje hacia el olvido? Este tipo de acontecimiento a gran escala se denomina Gran Filtro, y la IA es uno de los temas más populares de especulación sobre ellos. ¿Podría el inevitable desarrollo de la IA por parte de las civilizaciones tecnológicas crear el improbable Gran Silencio que escuchamos del universo?

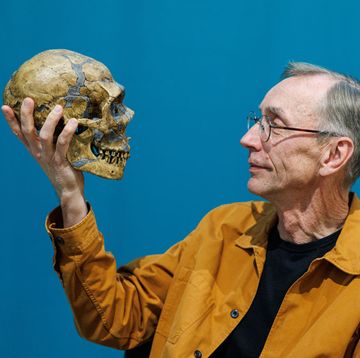

Michael Garrett es radioastrónomo de la Universidad de Manchester y director del Centro de Astrofísica de Jodrell Bank, con una amplia participación en la Búsqueda de Inteligencia Extraterrestre (SETI). Básicamente, aunque sus intereses de investigación son eclécticos, es una versión altamente cualificada y con credenciales de las personas que en las series de televisión o en las películas escuchan el universo para oír señales de otras civilizaciones. En este trabajo, revisado por expertos y publicado en la revista de la Academia Internacional de Astronáutica, compara las teorías sobre la superinteligencia artificial con observaciones concretas mediante radioastronomía.

Garrett explica en el artículo que los científicos se sienten cada vez más inquietos cuanto más tiempo pasa sin que oigamos ninguna señal de otra vida inteligente. "Este 'Gran Silencio' presenta una especie de paradoja cuando se yuxtapone con otros hallazgos astronómicos que implican que el universo es hospitalario para la aparición de vida inteligente", escribe. "A menudo se emplea el concepto de 'gran filtro': se trata de una barrera universal y un desafío insuperable que impide la aparición generalizada de vida inteligente".

Existen innumerables Grandes Filtros potenciales, desde la extinción climática hasta (¡gulp!) una pandemia global perniciosa. Cualquier número de acontecimientos podría impedir que una civilización global se convirtiera en multiplanetaria. Para las personas que siguen y creen más ideológicamente en las teorías de los Grandes Filtros, el asentamiento humano en Marte o en la Luna representa una forma de reducir el riesgo. (Pasará mucho tiempo, si es que llega a pasar, antes de que dispongamos de la tecnología necesaria para que estos asentamientos sean sostenibles e independientes). Cuanto más tiempo permanezcamos en la Tierra, más probable será que un Gran Filtro acabe con nosotros.

Hoy en día, la IA no es capaz de nada parecido a la inteligencia humana. Pero, según Garrett, está haciendo trabajos que antes la gente no creía que los ordenadores pudieran hacer. Si esta trayectoria conduce a la llamada inteligencia artificial general (IAG) -una distinción clave que significa un algoritmo que puede razonar y sintetizar ideas de una manera verdaderamente humana combinado con una increíble potencia de cálculo- podríamos estar realmente en problemas. En este artículo, Garrett sigue una cadena de ideas hipotéticas hasta llegar a una posible conclusión. ¿Cuánto tardaría una civilización en ser aniquilada por su propia GAI no regulada?

Por desgracia, en el escenario de Garrett, sólo se tarda entre 100 y 200 años. La codificación y el desarrollo de la IA es un proyecto de una sola mente que implica y se acelera por los datos y la potencia de procesamiento, explica, en comparación con el trabajo desordenado y multidominio de los viajes espaciales y la colonización. Hoy vemos esta división con el flujo de investigadores hacia los campos de la informática, frente a la escasez en las ciencias de la vida. Todos los días en Twitter, multimillonarios ruidosos hablan de lo grande e importante que es colonizar Marte, pero todavía no sabemos ni siquiera cómo sobrevivirán los humanos al viaje sin ser destrozados por la radiación cósmica. No hagas caso a ese hombre detrás de la cortina.

Hay algunas grandes advertencias, o simplemente cosas a tener en cuenta, sobre esta investigación. Garrett pasa por una serie de escenarios hipotéticos específicos, y utiliza enormes suposiciones. Asume que hay vida en la Vía Láctea y que la IA y la IAG son "desarrollos naturales" de estas civilizaciones. Utiliza la ya hipotética Ecuación de Drake, una forma de cuantificar el número probable de otras civilizaciones planetarias, que tiene varias variables de las que no tenemos una idea concreta.

Sin embargo, el argumento hipotético mixto llega a una conclusión contundente: la necesidad de una regulación fuerte y continua de la IA. Garrett señala que las naciones de la Tierra ya están inmersas en una carrera de productividad, con miedo a perderse si vacilan a la hora de llevar a cabo una mayor regulación. Algunos futuristas equivocados también tienen la extraña idea de que pueden subvertir la IAG simplemente desarrollando una moralmente buena, más rápida, para poder controlarla más, un argumento que no tiene sentido.

En el modelo de Garrett, estas civilizaciones tienen sólo un par de cientos de años en sus eras de IA antes de desaparecer del mapa. Con la distancia y el larguísimo transcurso del tiempo cósmico, estos plazos tan diminutos no significan casi nada. Se reducen a cero, lo que, dice, encaja con la actual tasa de éxito del SETI, del 0 por ciento. "Sin una regulación práctica, hay muchas razones para creer que la IA podría representar una gran amenaza para el curso futuro no sólo de nuestra civilización técnica, sino de todas las civilizaciones técnicas", explica Garrett.

Caroline Delbert is a writer, avid reader, and contributing editor at Pop Mech. She's also an enthusiast of just about everything. Her favorite topics include nuclear energy, cosmology, math of everyday things, and the philosophy of it all.